Denken Sie darüber nach. Warum erstellen Sie eine Website? Damit Ihre potenziellen Kunden oder Ihr Publikum Sie leicht finden können und damit Sie sich von der Konkurrenz abheben, richtig? Wie wird Ihr Inhalt tatsächlich gesehen? Wird aller Inhalt auf Ihrer Seite immer gesehen?

Warum Sie alle Seiten auf Ihrer Website finden müssen

Es ist möglich, dass Seiten, die wertvolle Informationen enthalten, die tatsächlich gesehen werden müssen, überhaupt nicht gesehen werden. Wenn dies bei Ihrer Website der Fall ist, verlieren Sie wahrscheinlich erheblichen Traffic oder sogar potenzielle Kunden.

Es könnte auch Seiten geben, die selten gesehen werden, und wenn sie es werden, stoßen Benutzer/Besucher/potenzielle Kunden auf eine Sackgasse, da sie keine anderen Seiten aufrufen können. Sie können nur gehen. Das ist genauso schlecht wie jene Seiten, die nie gesehen werden. Google wird beginnen, die hohen Absprungraten zu bemerken und die Glaubwürdigkeit Ihrer Website in Frage zu stellen. Dies wird dazu führen, dass Ihre Webseiten immer niedriger eingestuft werden.

Wie Ihr Inhalt tatsächlich gesehen wird

Für Benutzer, Besucher oder potenzielle Kunden, um Ihren Inhalt zu sehen, muss das Crawling und Indexieren durchgeführt werden und das häufig. Was ist Crawling und Indexieren?

Was ist Crawling und Indizierung?

Damit Google Ihren Inhalt Nutzern/Besuchern/potenziellen Kunden anzeigen kann, muss es zunächst wissen, dass der Inhalt existiert. Dies geschieht durch Crawling. Dabei suchen Suchmaschinen nach neuem Inhalt und fügen ihn ihrer Datenbank bereits vorhandener Inhalte hinzu.

Was macht das Crawlen möglich?

- Links

- Sitemaps

- Inhaltsverwaltungssysteme (CMS - Wix, Blogger)

Links:

Wenn Sie einen Link von einer bestehenden Seite zu einer anderen neuen Seite hinzufügen, zum Beispiel über Ankertext, können Suchmaschinen-Bots oder -Spinnen der neuen Seite folgen und sie zur Google-Datenbank für zukünftige Referenzen hinzufügen.

Sitemaps:

Diese sind auch bekannt als XML-Sitemaps. Hier reicht der Seiteninhaber eine Liste aller seiner Seiten bei der Suchmaschine ein. Der Webmaster kann auch Details wie das Datum der letzten Änderung hinzufügen. Die Seiten werden dann gecrawlt und zur ‚Datenbank‘ hinzugefügt. Dies geschieht jedoch nicht in Echtzeit. Ihre neuen Seiten oder Inhalte werden nicht gecrawlt, sobald Sie Ihre Sitemap einreichen. Das Crawling kann nach Tagen oder Wochen erfolgen.

Die meisten Websites, die ein Content Management System (CMS) verwenden, generieren diese automatisch, also ist es eine Art Abkürzung. Die einzige Zeit, in der eine Website möglicherweise nicht die Sitemap generiert hat, ist, wenn Sie eine Website von Grund auf neu erstellt haben.

CMS:

Wenn Ihre Website von einem CMS wie Blogger oder Wix betrieben wird, kann der Hosting-Anbieter (in diesem Fall das CMS) „Suchmaschinen anweisen, alle neuen Seiten oder Inhalte auf Ihrer Website zu durchsuchen.“

Hier sind einige Informationen, die Ihnen bei dem Prozess helfen:

Eine Sitemap zu WordPress hinzufügen

Was ist Indexierung?

Indexierung in einfachen Worten ist das Hinzufügen der gecrawlten Seiten und Inhalte zur 'Datenbank' von Google, die eigentlich als Googles Index bezeichnet wird.

Bevor Inhalte und Seiten zum Index hinzugefügt werden, bemühen sich die Suchmaschinen-Bots, die Seite und die darauf befindlichen Inhalte zu verstehen. Sie gehen sogar so weit, Dateien wie Bilder und Videos zu katalogisieren.

Deshalb ist als Webmaster die On-Page-SEO sehr nützlich (Seitentitel, Überschriften und die Verwendung von Alt-Texten unter anderem). Wenn deine Seite oder Seiten diese Aspekte haben, wird es für Google einfacher, deinen Inhalt zu „verstehen“, ihn angemessen zu katalogisieren und korrekt zu indizieren.

Verwendung von robots.txt

Manchmal möchten Sie vielleicht nicht, dass einige Seiten indexiert werden, oder Teile einer Website. Sie müssen Suchmaschinen-Bots Anweisungen geben. Die Verwendung solcher Anweisungen erleichtert auch das Crawlen und Indexieren, da weniger Seiten gecrawlt werden. Erfahren Sie mehr über robots.txt hier.

Verwendung von ‘noindex’

Sie können auch diese andere Direktive verwenden, wenn es Seiten gibt, die Sie nicht in den Suchergebnissen erscheinen lassen möchten. Erfahren Sie mehr über das noindex.

Bevor Sie beginnen, noindex hinzuzufügen, sollten Sie alle Ihre Seiten identifizieren, damit Sie Ihre Website aufräumen und es den Crawlern erleichtern können, Ihre Website ordnungsgemäß zu durchsuchen und zu indizieren.

Was sind einige Gründe, warum Sie alle Ihre Seiten finden müssen?

Was sind verwaiste Seiten?

Eine Waisenseite kann als eine Seite definiert werden, die keine Verlinkungen von anderen Seiten Ihrer Website hat. Dies macht es fast unmöglich, dass diese Seiten von Suchmaschinenbots gefunden werden, und zusätzlich auch von Benutzern. Wenn die Bots die Seite nicht finden können, dann werden sie sie auch nicht in den Suchergebnissen anzeigen, was die Chancen, dass Benutzer sie finden, weiter verringert.

Wie entstehen verwaiste Seiten?

Verwaiste Seiten können durch den Versuch entstehen, Inhalte privat zu halten, Syntaxfehler, Tippfehler, doppelte Inhalte oder abgelaufene Inhalte, die nicht verlinkt wurden. Hier sind weitere Möglichkeiten:

- Testseiten, die für A/B-Tests verwendet wurden und nie deaktiviert wurden

- Landing-Pages, die auf einer Saison basierten, zum Beispiel Weihnachten, Thanksgiving oder Ostern

- ‘Vergessene’ Seiten als Ergebnis einer Website-Migration

Wie steht es mit Sackgassenseiten?

Im Gegensatz zu Waisenseiten haben Sackgassenseiten Verlinkungen von anderen Seiten auf der Webseite, verlinken aber nicht zu anderen externen Seiten. Beispiele für Sackgassenseiten sind Dankesseiten, Dienstleistungsseiten ohne Handlungsaufforderungen und „Nichts gefunden“-Seiten, wenn Benutzer über die Suchfunktion etwas suchen.

Wenn Sie Sackgassenseiten haben, haben Besucher, die sie besuchen, nur zwei Optionen: die Seite verlassen oder zur vorherigen Seite zurückkehren. Das bedeutet, dass Sie bedeutenden Traffic verlieren, besonders wenn diese Seiten 'Hauptseiten' auf Ihrer Website sind. Noch schlimmer, Benutzer bleiben entweder frustriert, verwirrt oder fragen sich 'was kommt als Nächstes'?

Wenn Benutzer Ihre Website frustriert, verwirrt oder mit anderen negativen Emotionen verlassen, ist es unwahrscheinlich, dass sie zurückkehren, genau wie unzufriedene Kunden wahrscheinlich nie wieder bei einer Marke kaufen werden.

Woher kommen Sackgassenseiten?

Dead-End-Seiten sind das Ergebnis von Seiten ohne Handlungsaufforderungen. Ein Beispiel hierfür wäre eine Über-uns-Seite, die auf die Dienstleistungen hinweist, die Ihr Unternehmen anbietet, aber keinen Link zu diesen Dienstleistungen hat. Sobald der Leser versteht, was Ihr Unternehmen antreibt, welche Werte Sie vertreten, wie das Unternehmen gegründet wurde und welche Dienstleistungen Sie anbieten und bereits begeistert ist, müssen Sie ihm sagen, was er als Nächstes tun soll.

Ein einfacher Aufruf zum Handeln-Button „Unsere Dienstleistungen ansehen“ wird die Aufgabe erfüllen. Stellen Sie sicher, dass der Button beim Klicken tatsächlich zur Dienstleistungsseite führt. Sie möchten nicht, dass der Benutzer mit einer 404-Seite konfrontiert wird, was ihn/sie ebenfalls frustrieren würde.

Was sind versteckte Seiten?

Versteckte Seiten sind solche, die nicht über ein Menü oder eine Navigation zugänglich sind. Obwohl ein Besucher sie möglicherweise einsehen kann, insbesondere durch Ankertext oder eingehende Links, können sie schwer zu finden sein.

Seiten, die in den Kategoriebereich fallen, sind wahrscheinlich auch versteckte Seiten, da sie sich im Admin-Panel befinden. Die Suchmaschine kann möglicherweise nie auf sie zugreifen, da sie nicht auf Informationen zugreift, die in Datenbanken gespeichert sind.

Versteckte Seiten können auch das Ergebnis von Seiten sein, die nie zur Sitemap der Website hinzugefügt wurden, aber auf dem Server existieren.

Sollten alle versteckten Seiten entfernt werden?

Nicht wirklich. Es gibt versteckte Seiten, die absolut notwendig sind und niemals über Ihre Navigation zugänglich sein sollten. Lassen Sie uns Beispiele anschauen:

Anmeldungen zum Newsletter

Sie können eine Seite haben, die die Vorteile des Abonnierens des Newsletters aufschlüsselt, wie häufig Benutzer erwarten sollten, ihn zu erhalten, oder eine Grafik, die den Newsletter (oder vorherigen Newsletter) zeigt. Denken Sie daran, auch den Anmeldelink einzufügen.

Seiten mit Benutzerinformationen

Seiten, die von den Nutzern verlangen, ihre Informationen zu teilen, sollten definitiv versteckt sein. Nutzer müssen Konten erstellen, bevor sie darauf zugreifen können. Anmeldungen für Newsletter können ebenfalls hier eingeordnet werden.

Wie man versteckte Seiten findet

Wie wir erwähnt haben, können Sie versteckte Seiten mit allen Methoden finden, die verwendet werden, um verwaiste oder Sackgassen-Seiten zu finden. Lassen Sie uns noch einige weitere erkunden.

Verwendung von robots.txt

Versteckte Seiten sind höchstwahrscheinlich über robots.txt für Suchmaschinen verborgen. Um auf die robots.txt einer Website zuzugreifen, geben Sie [Domainname]/robots.txt in einen Browser ein und drücken Sie die Eingabetaste. Ersetzen Sie 'Domainname' durch den Domainnamen Ihrer Website. Achten Sie auf Einträge, die mit 'disallow' oder 'nofollow' beginnen.

Manuelles Finden

Wenn Sie zum Beispiel Produkte über Ihre Website verkaufen und vermuten, dass eine Ihrer Produktkategorien möglicherweise versteckt ist, können Sie manuell danach suchen. Dazu kopieren und fügen Sie die URL eines anderen Produkts ein und bearbeiten sie entsprechend. Wenn Sie es nicht finden, dann hatten Sie recht!.

Was ist, wenn Sie keine Ahnung haben, was die versteckten Seiten sein könnten? Wenn Sie Ihre Website in Verzeichnissen organisieren, können Sie Ihren Domainnamen/Ordner-Namen zu einem Browser der Website hinzufügen und durch die Seiten und Unter-Verzeichnisse navigieren.

Sobald Sie Ihre versteckten Seiten gefunden haben (und sie müssen nicht versteckt bleiben, wie oben besprochen), müssen Sie sie zu Ihrer Sitemap hinzufügen und eine Crawling-Anfrage einreichen.

So finden Sie alle Seiten auf Ihrer Website

Sie müssen alle Ihre Webseiten finden, um zu wissen, welche Sackgassen oder Waisen sind. Lassen Sie uns die verschiedenen Wege erkunden, um dies zu erreichen:

Verwenden Ihrer Sitemap-Datei

Wir haben uns bereits Sitemaps angeschaut. Ihre Sitemap wäre nützlich, wenn Sie alle Ihre Webseiten analysieren. Wenn Sie keine Sitemap haben, können Sie einen Sitemap-Generator verwenden, um eine für Sie zu erstellen. Alles, was Sie tun müssen, ist Ihren Domain-Namen einzugeben und die Sitemap wird für Sie generiert.

Verwendung Ihres CMS

Wenn Ihre Website von einem Content-Management-System (CMS) wie WordPress betrieben wird und Ihre Sitemap nicht alle Links enthält, ist es möglich, die Liste aller Ihrer Webseiten aus dem CMS zu generieren. Um dies zu tun, verwenden Sie ein Plugin wie Export All URLs.

Verwendung eines Logs

Ein Protokoll aller Seiten, die den Besuchern bereitgestellt wurden, ist ebenfalls nützlich. Um auf das Protokoll zuzugreifen, melden Sie sich bei Ihrem cPanel an und suchen Sie nach „Rohprotokolldateien“. Alternativ bitten Sie Ihren Hosting-Anbieter, es zu teilen. Auf diese Weise sehen Sie die am häufigsten besuchten Seiten, die nie besuchten Seiten und diejenigen mit den höchsten Abbruchraten. Seiten mit hohen Absprungraten oder ohne Besucher könnten Sackgassen- oder Waisenseiten sein.

Verwendung von Google Analytics

Hier sind die Schritte, die befolgt werden müssen:

Schritt 1: Melden Sie sich auf Ihrer Analytics-Seite an.

Schritt 2: Gehe zu „Verhalten“ dann zu „Seiteninhalt“

Schritt 3: Gehe zu „alle Seiten“

Schritt 4: Scrollen Sie nach unten und wählen Sie rechts „Zeilen anzeigen“

Schritt 5: Wählen Sie 500 oder 1000, je nachdem, wie viele Seiten Sie schätzen, dass Ihre Website hat

Schritt 6: Scrollen Sie nach oben und wählen Sie oben rechts "exportieren"

Schritt 7: Wählen Sie ‚exportieren als .xlsx‘ (Excel)

Schritt 8: Nachdem die Excel-Datei exportiert wurde, wählen Sie ‚dataset 1‘

Schritt 9: Nach „einzigartigen Seitenaufrufen“ sortieren.

Schritt 10: Löschen Sie alle anderen Zeilen und Spalten bis auf die mit Ihren URLs

Schritt 11: Verwenden Sie diese Formel für die zweite Spalte:

=CONCATENATE(„http://domain.com“,A1)

Schritt 12: Ersetzen Sie die Domain durch die Domain Ihrer Website. Ziehen Sie die Formel, sodass sie auch auf die anderen Zellen angewendet wird.

Sie haben jetzt alle Ihre URLs.

Wenn Sie sie in Hyperlinks umwandeln möchten, um sie beim Nachschlagen leicht anklicken und darauf zugreifen zu können, fahren Sie mit Schritt 13 fort.

Schritt 13: Verwenden Sie diese Formel in der dritten Zeile:

=HYPERLINK(B1)

Ziehen Sie die Formel, sodass sie auch auf die anderen Zellen angewendet wird.

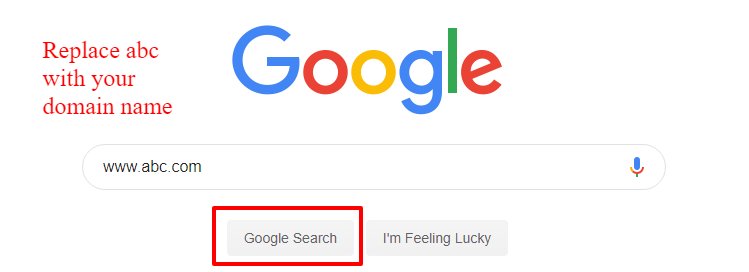

Manuelle Eingabe in die Suchanfrage von Google

Sie können auch diese Seite eingeben: www.abc.com in die Suchanfrage von Google. Ersetzen Sie ‚abc‘ durch Ihren Domainnamen. Sie erhalten Suchergebnisse mit allen URLs, die Google gecrawlt und indexiert hat, einschließlich Bilder, Links zu Erwähnungen auf anderen Seiten und sogar Hashtags, mit denen Ihre Marke verknüpft werden kann.

Sie können sie dann manuell kopieren und in eine Excel-Tabelle einfügen.

Was machen Sie dann mit Ihrer URL-Liste?

An dieser Stelle fragen Sie sich vielleicht, was Sie mit Ihrer URL-Liste tun müssen. Lassen Sie uns die verfügbaren Optionen betrachten:

Manueller Vergleich mit Log-Daten

Eine der Optionen wäre, Ihre URL-Liste manuell mit dem CMS-Log zu vergleichen und die Seiten zu identifizieren, die anscheinend überhaupt keinen Traffic haben oder die anscheinend die höchsten Absprungraten aufweisen. Sie können dann ein Tool wie unseres verwenden, um eingehende und ausgehende Links für jede der Seiten zu überprüfen, von denen Sie vermuten, dass sie verwaist oder Sackgassen sind.

Ein anderer Ansatz besteht darin, alle Ihre URLs als .xlsx-Datei (Excel) herunterzuladen und auch Ihr Protokoll. Vergleichen Sie sie nebeneinander (zum Beispiel in zwei Spalten) und verwenden Sie dann die Option „Duplikate entfernen“ in Excel. Befolgen Sie die Schritt-für-Schritt-Anweisungen. Am Ende des Prozesses werden nur noch verwaiste und Sackgassen-Seiten übrig sein.

Der dritte Vergleichsansatz besteht darin, zwei Datensätze - Ihr Protokoll und die URL-Liste - in Google Sheets zu kopieren. Dies ermöglicht Ihnen die Verwendung dieser Formel: =SVERWEIS(A1; A:B; 2;) um URLs zu suchen, die in Ihrer URL-Liste vorhanden sind, aber nicht in Ihrem Protokoll. Die fehlenden Seiten (als N/A dargestellt) sollten als verwaiste Seiten interpretiert werden. Stellen Sie sicher, dass die Protokolldaten in der ersten oder linken Spalte stehen.

Verwendung von Website-Crawling-Tools

Die andere Option wäre, Ihre URL-Liste in Tools zu laden, die Website-Crawls durchführen können, zu warten, bis sie die Website gecrawlt haben, und dann Ihre URLs in eine Tabelle zu kopieren und einzufügen, bevor Sie sie einzeln analysieren und versuchen herauszufinden, welche davon verwaist oder Sackgassen sind.

Diese beiden Optionen können zeitaufwendig sein, besonders wenn Sie viele Seiten auf Ihrer Website haben, nicht wahr?

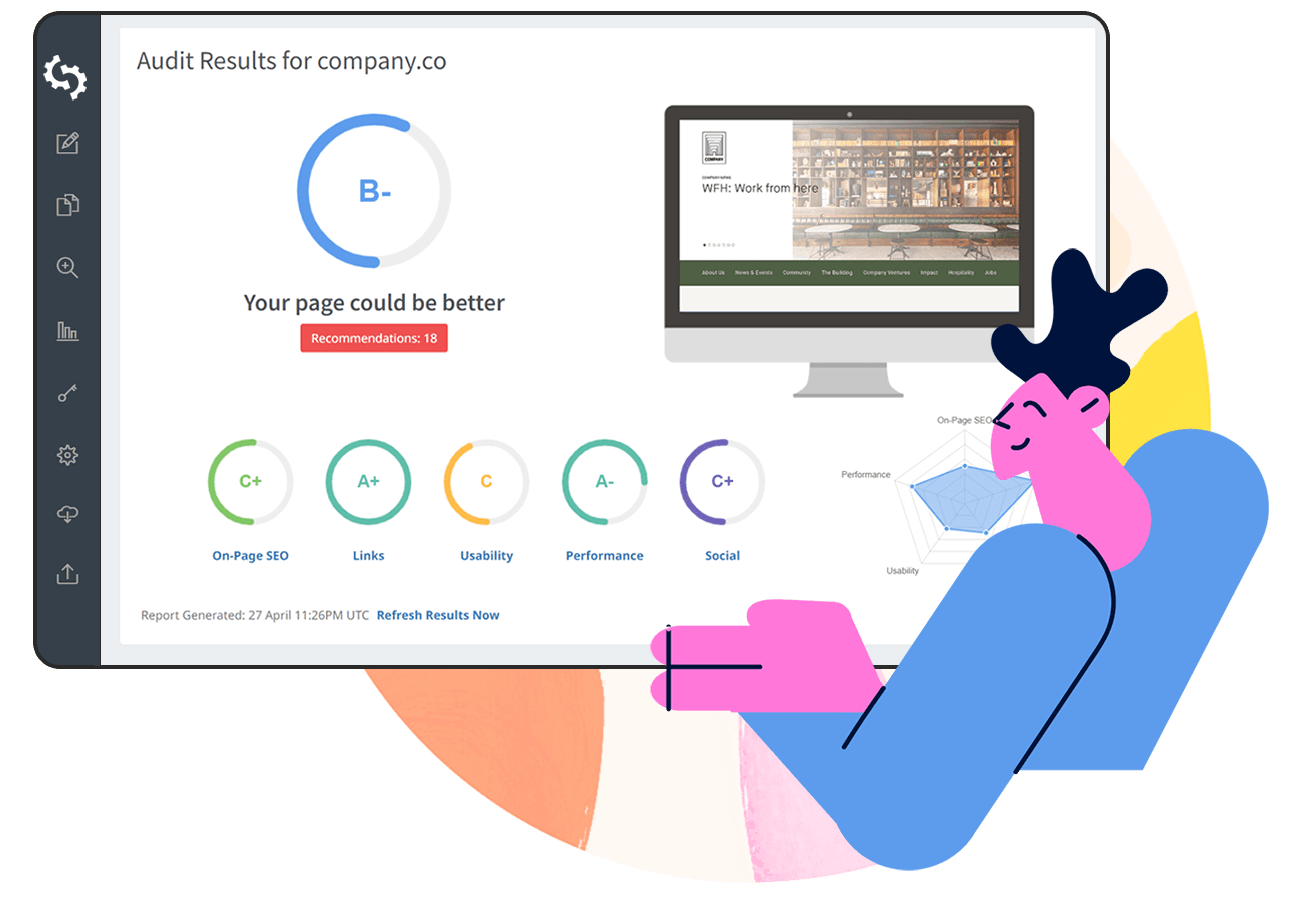

Nun, wie wäre es mit einem Tool, das nicht nur alle Ihre URLs findet, sondern Ihnen auch erlaubt, sie zu filtern und ihren Status anzeigt (damit Sie wissen, welche Sackgassen oder Waisen sind?). Mit anderen Worten, wenn Sie eine Abkürzung suchen, um alle Seiten Ihrer Website zu finden, nutzen Sie das SEO Crawl Tool von SEOptimer.

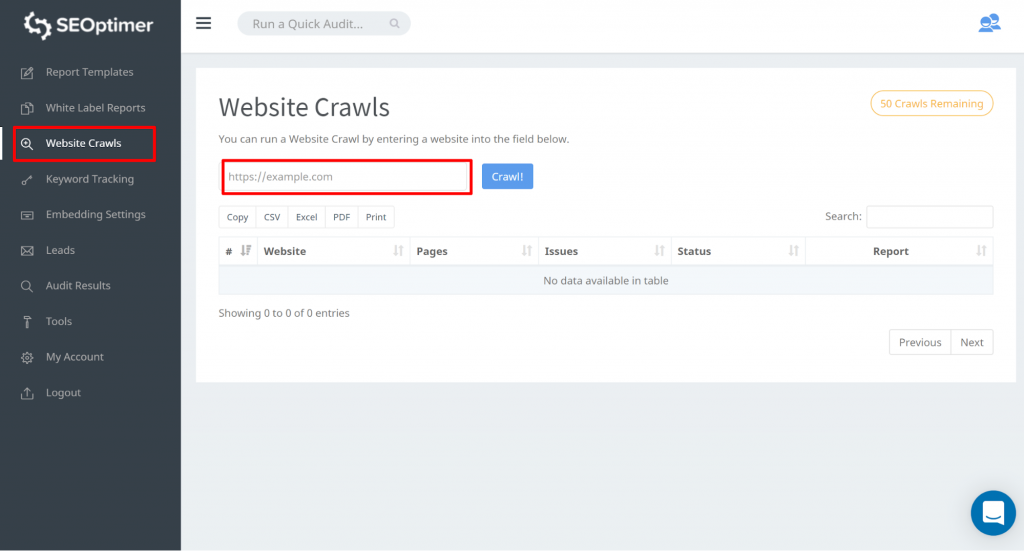

SEOptimers SEO Crawl Tool

Dieses Tool ermöglicht es Ihnen, auf alle Ihre Seiten Ihrer Website zuzugreifen. Sie können beginnen, indem Sie zu „Website Crawls“ gehen und Ihre Website-URL eingeben. Klicken Sie auf „Crawl“

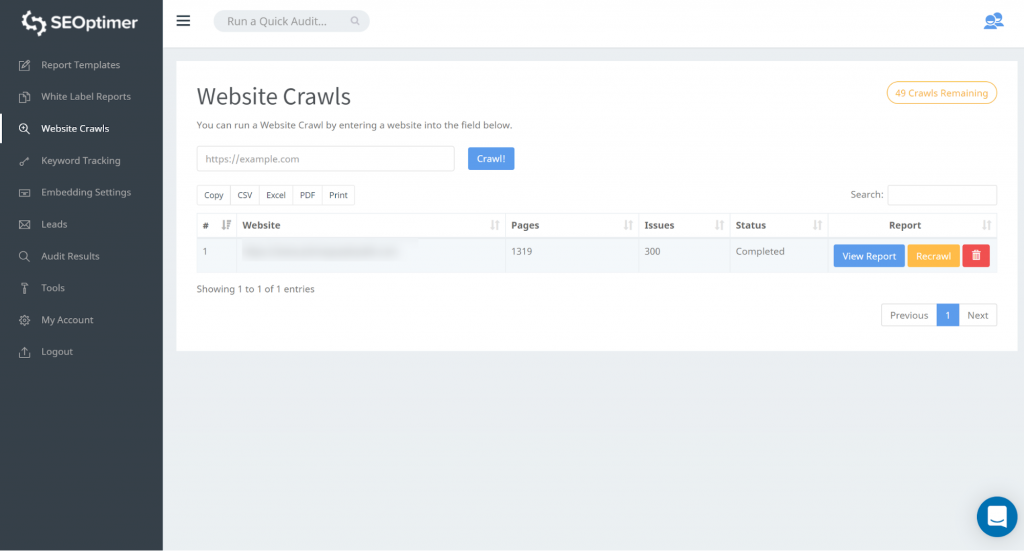

Sobald der Crawl abgeschlossen ist, können Sie auf „Bericht anzeigen“ klicken:

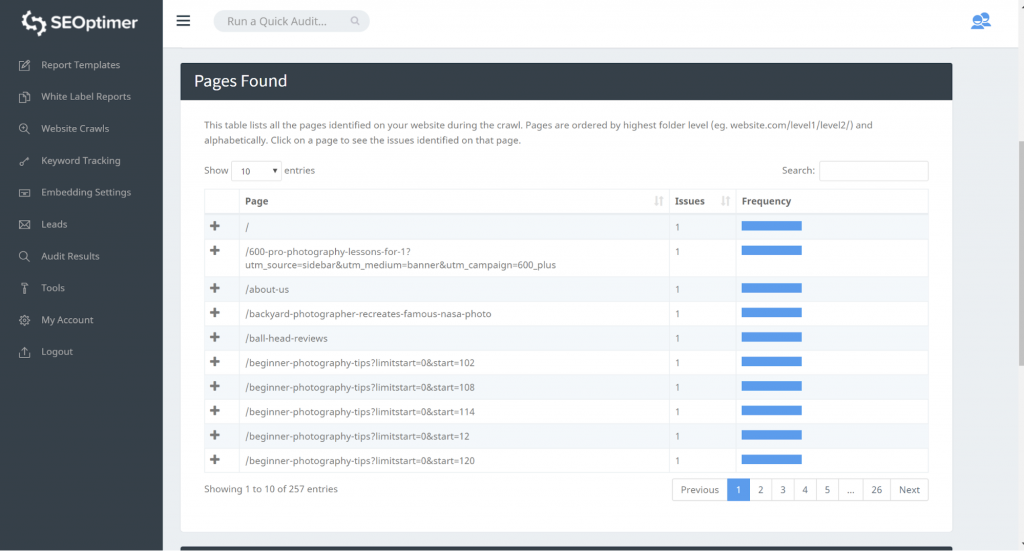

Unser Crawl-Tool wird alle Seiten Ihrer Website erkennen und sie im Abschnitt „Seite gefunden“ des Crawls auflisten.

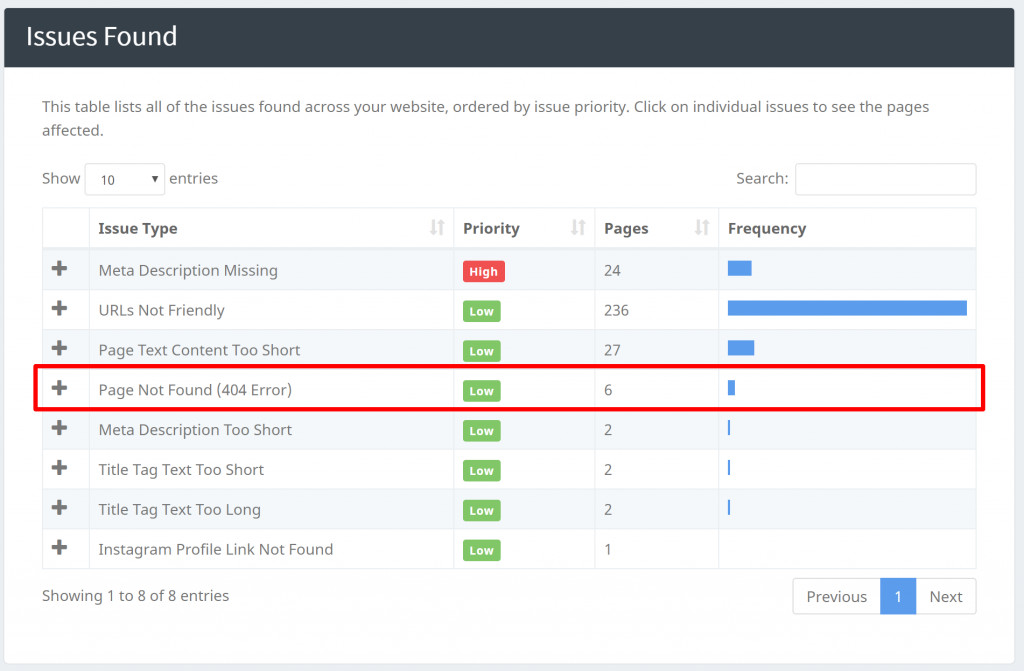

Sie können „404-Fehler“ Probleme in unserem „Gefundene Probleme“ direkt unter dem Abschnitt „Gefundene Seiten“ identifizieren:

Unsere Crawler können auch andere Probleme identifizieren, wie das Auffinden von Seiten mit fehlendem Titel, Meta-Beschreibungen usw. Sobald Sie alle Ihre Seiten gefunden haben, können Sie mit dem Filtern beginnen und an den vorliegenden Problemen arbeiten.

Zum Schluss

In diesem Artikel haben wir uns damit beschäftigt, wie man alle Seiten auf Ihrer Website findet und warum das wichtig ist. Wir haben auch Konzepte wie verwaiste und Sackgassen-Seiten sowie versteckte Seiten erkundet. Wir haben jede einzelne unterschieden, wie man jede unter Ihren URLs identifiziert. Es gibt keinen besseren Zeitpunkt herauszufinden, ob Sie aufgrund von versteckten, verwaisten oder Sackgassen-Seiten Verluste erleiden.